https://agent-skills.md

Advent of Claude: 31 Days of Claude Code https://adocomplete.com/advent-of-claude-2025/

在 opencode 中使用 Codex 模型https://xairouter.com/blog/opencode-xairouter/

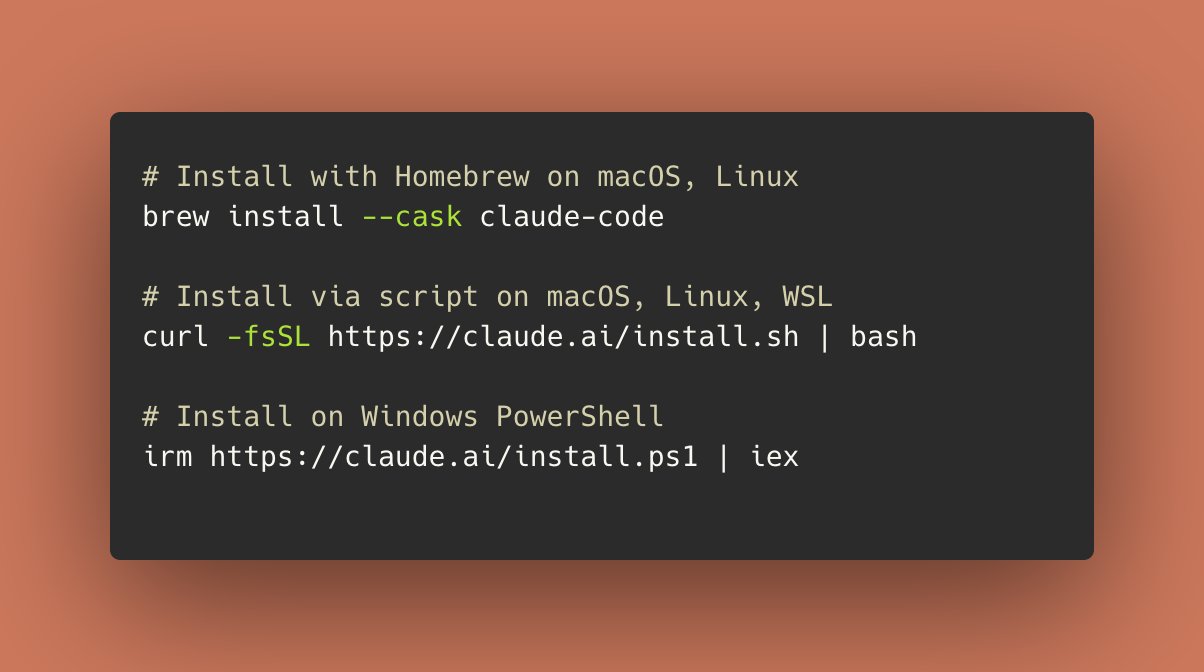

The Complete Guide to Building Agents with the Claude Agent SDK使用 Claude Agent SDK 构建智能体的完整指南If you've used Claude Code, you've seen what an AI agent can actually do: read files, run commands, edit code, figure out the steps to accomplish a task. 如果你使用过 Claude Code,你就知道 AI 代理实际上能做什么:读取文件、运行命令、编辑代码、找出完成任务所需的步骤。And you know it doesn't just help you write code, it takes ownership of problems and works through them the way a thoughtful engineer would.你也知道,它不仅仅帮助你编写代码,还会主动承担问题,像一位细心的工程师一样去解决它们。The Claude Agent SDK is the same engine, yours to point at whatever problem you want, so you can easily build agents of your own.Claude Agent SDK 使用的是相同的引擎,你可以将其指向任何你想要解决的问题,轻松构建属于你自己的智能代理。It's the infrastructure behind Claude Code, exposed as a library. You get the agent loop, the built-in tools, the context management, basically everything you'd otherwise have to build yourself.这是 Claude Code 背后的基础设施,现已作为库公开。你可以获得代理循环、内置工具、上下文管理功能,基本上所有原本需要自行构建的内容都已包含在内。This guide walks through building a code review agent from scratch. By the end, you'll have something that can analyze a codebase, find bugs and security issues, and return structured feedback.本指南将带你从零开始构建一个代码审查代理。完成之后,你将拥有一款能够分析代码库、发现漏洞和安全问题,并返回结构化反馈的工具。More importantly, you'll understand how the SDK works so you can build whatever you actually need.更重要的是,你将理解 SDK 的工作原理,从而能够构建真正需要的功能。What we're building我们正在构建的内容Our code review agent will:我们的代码审查代理将:Analyze a codebase for bugs and security issues分析代码库中的错误和安全问题Read files and search through code autonomously自主读取文件并在代码中进行搜索Provide structured, actionable feedback提供结构化且可操作的反馈Track its progress as it works跟踪其运行进度The stack堆栈• Runtime - Claude Code CLI• SDK - @anthropic-ai/claude-agent-sdk• Language - TypeScript • Model - Claude Opus 4.5• 运行时 - Claude Code CLI• SDK - @anthropic-ai/claude-agent-sdk• 语言 - TypeScript• 模型 - Claude Opus 4.5What the SDK gives youSDK 提供的功能If you've built agents with the raw API, you know the pattern: call the model, check if it wants to use a tool, execute the tool, feed the result back, repeat until done. This can get tedious when building anything non-trivial.如果你使用原始 API 构建过智能体,就会熟悉这个模式:调用模型,检查它是否需要使用工具,执行工具,将结果反馈回去,重复此过程直到完成。当构建非简单任务时,这种流程会变得非常繁琐。```The SDK handles that loop:SDK 会处理这个循环:typescript// Without the SDK: You manage the looplet response = await client.messages.create({...});while (response.stop_reason === "tool_use") { const result = yourToolExecutor(response.tool_use); response = await client.messages.create({ tool_result: result, ... });}// With the SDK: Claude manages itfor await (const message of query({ prompt: "Fix the bug in auth.py" })) { console.log(message); // Claude reads files, finds bugs, edits code}```You also get working tools out of the box:你还可以直接使用现成的工具:• Read - read any file in the working directory• Write - create new files• Edit - make precise edits to existing files• Bash - run terminal commands• Glob - find files by pattern• Grep - search file contents with regex• WebSearch - search the web• WebFetch - fetch and parse web pages• 读取 - 读取工作目录中的任意文件• 写入 - 创建新文件• 编辑 - 对现有文件进行精确修改• Bash - 运行终端命令• Glob - 按模式查找文件• Grep - 使用正则表达式搜索文件内容• WebSearch - 搜索网络• WebFetch - 获取并解析网页You don't have to implement any of this yourself.您无需自行实现其中任何功能。Prerequisites先决条件Node.js 18+ installed已安装 Node.js 18+An Anthropic API key (get one here获取一个)Anthropic API 密钥(在此处获取)Getting started快速入门Step 1: Install Claude Code CLI步骤 1:安装 Claude Code CLIThe Agent SDK uses Claude Code as its runtime:Agent SDK 使用 Claude Code 作为其运行时:bashnpm install -g @anthropic-ai/claude-codeAfter installing, run claude in your terminal and follow the prompts to authenticate.安装完成后,在终端中运行 claude 命令,并按照提示完成身份验证。Step 2: Create your project步骤 2:创建您的项目bashmkdir code-review-agent && cd code-review-agentnpm init -ynpm install @anthropic-ai/claude-agent-sdknpm install -D typescript @types/node tsxStep 3: Set your API key步骤 3:设置您的 API 密钥bashexport ANTHROPIC_API_KEY=your-api-keyYour first agent你的第一个代理Create agent.ts:创建 agent.ts:typescriptimport { query } from "@anthropic-ai/claude-agent-sdk";async function main() { for await (const message of query({ prompt: "What files are in this directory?", options: { model: "opus", allowedTools: ["Glob", "Read"], maxTurns: 250 } })) { if (message.type === "assistant") { for (const block of message.message.content) { if ("text" in block) { console.log(block.text); } } } if (message.type === "result") { console.log("\nDone:", message.subtype); } }}main();Run it:运行它:bashnpx tsx agent.tsClaude will use the Glob tool to list files and tell you what it found.Claude 将使用 Glob 工具列出文件,并告诉你它找到了什么。Understanding the message stream理解消息流The query() function returns an async generator that streams messages as Claude works. Here are the key message types:query() 函数返回一个异步生成器,会在 Claude 处理过程中流式传输消息。以下是关键的消息类型:typescriptfor await (const message of query({ prompt: "..." })) { switch (message.type) { case "system": // Session initialization info if (message.subtype === "init") { console.log("Session ID:", message.session_id); console.log("Available tools:", message.tools); } break; case "assistant": // Claude's responses and tool calls for (const block of message.message.content) { if ("text" in block) { console.log("Claude:", block.text); } else if ("name" in block) { console.log("Tool call:", block.name); } } break; case "result": // Final result console.log("Status:", message.subtype); // "success" or error type console.log("Cost:", message.total_cost_usd); break; }}Building a code review agent构建一个代码审查代理Now let's build something useful. Create review-agent.ts:现在让我们构建一些有用的东西。创建 review-agent.ts:typescriptimport { query } from "@anthropic-ai/claude-agent-sdk";async function reviewCode(directory: string) { console.log(`\n🔍 Starting code review for: ${directory}\n`); for await (const message of query({ prompt: `Review the code in ${directory} for:1. Bugs and potential crashes2. Security vulnerabilities 3. Performance issues4. Code quality improvementsBe specific about file names and line numbers.`, options: { model: "opus", allowedTools: ["Read", "Glob", "Grep"], permissionMode: "bypassPermissions", // Auto-approve read operations maxTurns: 250 } })) { // Show Claude's analysis as it happens if (message.type === "assistant") { for (const block of message.message.content) { if ("text" in block) { console.log(block.text); } else if ("name" in block) { console.log(`\n📁 Using ${block.name}...`); } } } // Show completion status if (message.type === "result") { if (message.subtype === "success") { console.log(`\n✅ Review complete! Cost: $${message.total_cost_usd.toFixed(4)}`); } else { console.log(`\n❌ Review failed: ${message.subtype}`); } } }}// Review the current directoryreviewCode(".");Testing It Out测试一下Create a file with some intentional issues. Create example.ts:创建一个包含故意问题的文件。创建 example.ts:typescriptfunction processUsers(users: any) { for (let i = 0; i <= users.length; i++) { // Off-by-one error console.log(users[i].name.toUpperCase()); // No null check }}function connectToDb(password: string) { const connectionString = `postgres://admin:${password}@localhost/db`; console.log("Connecting with:", connectionString); // Logging sensitive data}async function fetchData(url) { // Missing type annotation const response = await fetch(url); return response.json(); // No error handling}Run the review:运行审查:bashnpx tsx review-agent.tsClaude will identify the bugs, security issues, and suggest fixes.Claude 将识别出错误、安全问题,并提出修复建议。Adding Structured Output添加结构化输出For programmatic use, you'll want structured data. The SDK supports JSON Schema output:对于程序化使用,您需要结构化数据。SDK 支持 JSON Schema 输出:typescriptimport { query } from "@anthropic-ai/claude-agent-sdk";const reviewSchema = { type: "object", properties: { issues: { type: "array", items: { type: "object", properties: { severity: { type: "string", enum: ["low", "medium", "high", "critical"] }, category: { type: "string", enum: ["bug", "security", "performance", "style"] }, file: { type: "string" }, line: { type: "number" }, description: { type: "string" }, suggestion: { type: "string" } }, required: ["severity", "category", "file", "description"] } }, summary: { type: "string" }, overallScore: { type: "number" } }, required: ["issues", "summary", "overallScore"]};async function reviewCodeStructured(directory: string) { for await (const message of query({ prompt: `Review the code in ${directory}. Identify all issues.`, options: { model: "opus", allowedTools: ["Read", "Glob", "Grep"], permissionMode: "bypassPermissions", maxTurns: 250, outputFormat: { type: "json_schema", schema: reviewSchema } } })) { if (message.type === "result" && message.subtype === "success") { const review = message.structured_output as { issues: Array<{ severity: string; category: string; file: string; line?: number; description: string; suggestion?: string; }>; summary: string; overallScore: number; }; console.log(`\n📊 Code Review Results\n`); console.log(`Score: ${review.overallScore}/100`); console.log(`Summary: ${review.summary}\n`); for (const issue of review.issues) { const icon = issue.severity === "critical" ? "🔴" : issue.severity === "high" ? "🟠" : issue.severity === "medium" ? "🟡" : "🟢"; console.log(`${icon} [${issue.category.toUpperCase()}] ${issue.file}${issue.line ? `:${issue.line}` : ""}`); console.log(` ${issue.description}`); if (issue.suggestion) { console.log(` 💡 ${issue.suggestion}`); } console.log(); } } }}reviewCodeStructured(".");Handling permissions处理权限By default, the SDK asks for approval before executing tools. You can customize this:默认情况下,SDK 在执行工具前会请求批准。您可以自定义此行为:Permission modes权限模式typescriptoptions: { // Standard mode - prompts for approval permissionMode: "default", // Auto-approve file edits permissionMode: "acceptEdits", // No prompts (use with caution) permissionMode: "bypassPermissions"}Custom permission handler自定义权限处理程序For fine-grained control, use canUseTool:如需更精细的控制,请使用 canUseTool:typescriptoptions: { canUseTool: async (toolName, input) => { // Allow all read operations if (["Read", "Glob", "Grep"].includes(toolName)) { return { behavior: "allow", updatedInput: input }; } // Block writes to certain files if (toolName === "Write" && input.file_path?.includes(".env")) { return { behavior: "deny", message: "Cannot modify .env files" }; } // Allow everything else return { behavior: "allow", updatedInput: input }; }}Creating subagents创建子代理For complex tasks, you can create specialized subagents:对于复杂任务,你可以创建专用的子代理:typescriptimport { query, AgentDefinition } from "@anthropic-ai/claude-agent-sdk";async function comprehensiveReview(directory: string) { for await (const message of query({ prompt: `Perform a comprehensive code review of ${directory}. Use the security-reviewer for security issues and test-analyzer for test coverage.`, options: { model: "opus", allowedTools: ["Read", "Glob", "Grep", "Task"], // Task enables subagents permissionMode: "bypassPermissions", maxTurns: 250, agents: { "security-reviewer": { description: "Security specialist for vulnerability detection", prompt: `You are a security expert. Focus on:- SQL injection, XSS, CSRF vulnerabilities- Exposed credentials and secrets- Insecure data handling- Authentication/authorization issues`, tools: ["Read", "Grep", "Glob"], model: "sonnet" } as AgentDefinition, "test-analyzer": { description: "Test coverage and quality analyzer", prompt: `You are a testing expert. Analyze:- Test coverage gaps- Missing edge cases- Test quality and reliability- Suggestions for additional tests`, tools: ["Read", "Grep", "Glob"], model: "haiku" // Use faster model for simpler analysis } as AgentDefinition } } })) { if (message.type === "assistant") { for (const block of message.message.content) { if ("text" in block) { console.log(block.text); } else if ("name" in block && block.name === "Task") { console.log(`\n🤖 Delegating to: ${(block.input as any).subagent_type}`); } } } }}comprehensiveReview(".");Session management会话管理For multi-turn conversations, capture and resume sessions:对于多轮对话,捕获并恢复会话:typescriptimport { query } from "@anthropic-ai/claude-agent-sdk";async function interactiveReview() { let sessionId: string | undefined; // Initial review for await (const message of query({ prompt: "Review this codebase and identify the top 3 issues", options: { model: "opus", allowedTools: ["Read", "Glob", "Grep"], permissionMode: "bypassPermissions", maxTurns: 250 } })) { if (message.type === "system" && message.subtype === "init") { sessionId = message.session_id; } // ... handle messages } // Follow-up question using same session if (sessionId) { for await (const message of query({ prompt: "Now show me how to fix the most critical issue", options: { resume: sessionId, // Continue the conversation allowedTools: ["Read", "Glob", "Grep"], maxTurns: 250 } })) { // Claude remembers the previous context } }}Using hooks使用钩子Hooks let you intercept and customize agent behavior:钩子(Hooks)让您能够拦截并自定义代理的行为:typescriptimport { query, HookCallback, PreToolUseHookInput } from "@anthropic-ai/claude-agent-sdk";const auditLogger: HookCallback = async (input, toolUseId, { signal }) => { if (input.hook_event_name === "PreToolUse") { const preInput = input as PreToolUseHookInput; console.log(`[AUDIT] ${new Date().toISOString()} - ${preInput.tool_name}`); } return {}; // Allow the operation};const blockDangerousCommands: HookCallback = async (input, toolUseId, { signal }) => { if (input.hook_event_name === "PreToolUse") { const preInput = input as PreToolUseHookInput; if (preInput.tool_name === "Bash") { const command = (preInput.tool_input as any).command || ""; if (command.includes("rm -rf") || command.includes("sudo")) { return { hookSpecificOutput: { hookEventName: "PreToolUse", permissionDecision: "deny", permissionDecisionReason: "Dangerous command blocked" } }; } } } return {};};for await (const message of query({ prompt: "Clean up temporary files", options: { model: "opus", allowedTools: ["Bash", "Glob"], maxTurns: 250, hooks: { PreToolUse: [ { hooks: [auditLogger] }, { matcher: "Bash", hooks: [blockDangerousCommands] } ] } }})) { // ...}Adding custom tools with MCP使用 MCP 添加自定义工具Extend Claude with custom tools using Model Context Protocol:通过模型上下文协议(MCP)为 Claude 扩展自定义工具:typescriptimport { query, tool, createSdkMcpServer } from "@anthropic-ai/claude-agent-sdk";import { z } from "zod";// Create a custom toolconst customServer = createSdkMcpServer({ name: "code-metrics", version: "1.0.0", tools: [ tool( "analyze_complexity", "Calculate cyclomatic complexity for a file", { filePath: z.string().describe("Path to the file to analyze") }, async (args) => { // Your complexity analysis logic here const complexity = Math.floor(Math.random() * 20) + 1; // Placeholder return { content: [{ type: "text", text: `Cyclomatic complexity for ${args.filePath}: ${complexity}` }] }; } ) ]});// Use streaming input for MCP serversasync function* generateMessages() { yield { type: "user" as const, message: { role: "user" as const, content: "Analyze the complexity of main.ts" } };}for await (const message of query({ prompt: generateMessages(), options: { model: "opus", mcpServers: { "code-metrics": customServer }, allowedTools: ["Read", "mcp__code-metrics__analyze_complexity"], maxTurns: 250 }})) { // ...}Cost tracking成本跟踪Track API costs for billing:跟踪 API 成本以用于计费:typescriptfor await (const message of query({ prompt: "..." })) { if (message.type === "result" && message.subtype === "success") { console.log("Total cost:", message.total_cost_usd); console.log("Token usage:", message.usage); // Per-model breakdown (useful with subagents) for (const [model, usage] of Object.entries(message.modelUsage)) { console.log(`${model}: $${usage.costUSD.toFixed(4)}`); } }}Production code review agent生产代码审查代理Here's a production-ready agent that ties everything together:这是一个可投入生产的代理,将所有功能整合在一起:typescriptimport { query, AgentDefinition } from "@anthropic-ai/claude-agent-sdk";interface ReviewResult { issues: Array<{ severity: "low" | "medium" | "high" | "critical"; category: "bug" | "security" | "performance" | "style"; file: string; line?: number; description: string; suggestion?: string; }>; summary: string; overallScore: number;}const reviewSchema = { type: "object", properties: { issues: { type: "array", items: { type: "object", properties: { severity: { type: "string", enum: ["low", "medium", "high", "critical"] }, category: { type: "string", enum: ["bug", "security", "performance", "style"] }, file: { type: "string" }, line: { type: "number" }, description: { type: "string" }, suggestion: { type: "string" } }, required: ["severity", "category", "file", "description"] } }, summary: { type: "string" }, overallScore: { type: "number" } }, required: ["issues", "summary", "overallScore"]};async function runCodeReview(directory: string): Promise

https://dlload.com

https://github.com/Myfastools/anytransfer

跟着 Anthropic 博客和文档,学习「Agent Skills」构建的最佳实践跟随 Anthropic 博客和文档,学习「Agent Skills」构建的最佳实践重新阅读了 Anthropic 工程博客和 Agent Skills 文档:1. https://anthropic.com/engineering/equipping-agents-for-the-real-world-with-agent-skills2. https://platform.claude.com/docs/en/agents-and-tools/agent-skills/best-practices在这两篇文章中,找到了 Agent Skills 构建的这几个关键原则和最佳实践,咱们是基于 Claude 来解读的,但同样适用于其他 AI Agents,咱们一起看看。先说结论:一个优秀 Skill 的“标准画像”· 名字(Name):使用动名词(如 processing-pdfs),清晰明确。· 描述(Description):用第三人称(如 "Processes Excel files..." 而不是 "I can help you..."),并包含具体的触发关键词。· 核心文件:一个精炼的 SKILL. md 作为“中控台”,若干个 .md 作为“专业手册”,以及一组 .py 或 .sh 脚本作为“精密工具”。1. “极简主义”:只提供 Claude 不知道的信息Claude 本身已经拥有庞大的知识库,上下文窗口是昂贵的公共资源。· 不要过度解释:如果 Claude 已经知道什么是 PDF 或 Git,不要在技能中解释这些基础概念。· 挑战每一行文字:问自己:“Claude 真的需要这段解释吗?”、“这段话的 Token 成本是否换回了足够的价值?”· 对比示例: · 反面(啰嗦):“PDF 是一种便携式文档格式,要提取它,你需要安装 pdfplumber 库...” · 正面(专业):直接给出代码示例 import pdfplumber; ...。2. 动态调节“自由度”:给 Claude 合适的约束根据任务的性质,决定给 Claude 多少发挥空间。· 高自由度(文字指令):适用于有多种路径可通向成功、需要根据上下文做决策的任务(如:代码审查、内容润色)。· 中自由度(带参数的脚本):适用于有固定模式但需要灵活配置的任务(如:生成周报、数据分析)。· 低自由度(固定脚本):适用于极度脆弱、不容出错的任务(如:数据库迁移、系统部署)。 · 金句:像对待机器人一样——在悬崖边的窄桥上,给它死指令(低自由度);在开阔的草原上,给它大方向(高自由度)。3. 利用“渐进式披露”结构化你的文件夹不要把所有东西都塞进一个 SKILL. md,这会迅速耗尽 Token。· 保持扁平化:官方建议参考链接只保留一层深度。即 SKILL. md 直接指向 reference. md,不要出现 SKILL. md -> A. md -> B. md 的深层嵌套。· 模块化拆分: · 如果技能涉及多个领域(如财务、销售),将它们拆分为 finance. md 和 sales. md。 · 在 SKILL. md 中做一个“目录”,Claude 只有在处理财务问题时才会去读取财务相关的详细文档。· 长文档技巧:如果一个参考文件超过 100 行,务必在顶部加一个目录。这能确保 Claude 即使只是部分预览文件,也能看到全貌。4. 强制执行“验证循环”这是提升 Agent 成功率最有效的工程手段。· Checklist 模式:让 Claude 在执行复杂任务前,先拷贝一份清单到回复中,每完成一步打一个钩。这能防止 Claude “偷懒”跳过关键步骤。· “运行 -> 校验 -> 修正”:在技能中包含验证脚本。 · 示例:修改 XML 文件后,强制 Claude 运行一个 validate. py。如果报错,Claude 必须根据错误信息自我修正,而不是直接报错退出。· 让 Claude 互检:如果不用代码,也可以让 Claude 根据 STYLE_GUIDE.md 来自我审计。5. 评价驱动开发:先写测试,再写技能不要凭空想象 Claude 需要什么,要从失败中学习。· 识别差距:先让 Claude 在没有技能的情况下执行任务,记录它在哪里跌倒了(例如:不知道公司的特定 API 格式)。· 最小化补足:只编写刚好能让它通过测试的那部分技能描述。· 模型差异化测试: · Haiku:需要更详细、直白的引导。 · Sonnet:需要高效、平衡的指令。 · Opus/4.5:非常聪明,要避免过度解释,否则它会觉得你太啰嗦而忽略重点。

https://github.com/K-Dense-AI/claude-scientific-skills

https://github.com/Auto-200/cc-agent-sdk

Claude Code in Actionhttps://anthropic.skilljar.com/claude-code-in-action

https://github.com/looplj/axonhub

我手下的三员大将claude --dangerously-skip-permissionscodex --sandbox workspace-write --ask-for-approval nevergemini -m gemini-3-flash-preview --yolo

https://chat.jan.ai

https://github.com/Lulzx/tinypdf

How to Set Up the Vertex AI API Key如何设置 Vertex AI API 密钥https://docs.aicontentlabs.com/articles/vertex-ai-api-key/

https://okpay.ai/login?invite=yw.gx

https://www.longfungx.com/card#/signUp?referralCode=G728

https://bandwagonhost.com/aff.php?aff=80321

假设日本法西斯余孽与右翼势力遭遇毁灭性打击,历史的死结或将就此解开:其一,美国背负的巨额债务枷锁由此粉碎;其二,中、俄、韩三国缠绕已久的领土争端将不复存在,东亚地缘政治的火药桶被彻底移除;其三,唯有剔除那些拒绝反省的历史垃圾,日本民族中仅存的良知才能在废墟中重生,走上真正的和平之路。如果数百万冥顽不灵者的消亡,能换来亚洲永久的太平与历史正义的终极偿还,那么这不仅是地缘的重塑,更是天道的轮回。

像中国和俄罗斯这样地域辽阔、历史上长期面临外敌入侵压力和内部离心力量的国家,中央集权往往是维持稳定与统一的自然选择。如果说多中心、竞争性的政治结构更优,那么为什么中国历史上多次出现类似“多国并立”的时期,例如战国七国、五代十国、北洋军阀时期,这些都在形式上更接近“多元政治”或“分权结构”,却往往伴随着长期战乱与社会动荡?为什么这些结构在历史自然演化中无法保留,反而每次都被重新统一、走向集中权力?因此我想进一步了解:你在评估国家治理模式、地缘政治定位与历史演化逻辑时,所依据的理论框架是什么?

https://anthropic.skilljar.com/claude-code-in-action

这份12月5日发布的《国家安全战略》(NSS),与其说是一份“进取”的蓝图,不如说是一份**“帝国焦虑”与“防御性进攻”**的心理诊断书。透过这份文件,我们可以清晰地看到美国决策层(特别是特朗普团队)当下的四种核心心态:### 1. “堡垒心态”:承认力有不逮,急于“回防老巢”这是这份文件最显著的心理转折。过去几十年,美国的心态是“世界警察”,认为全球任何角落的安全都与自己有关。但这份文件重提1823年的“门罗主义”,把重心猛然拉回西半球和边境,这暴露了美国深层的**战略疲劳感**。* **心态解读:** “外面的世界太乱、太花钱,我们也管不过来了。先把自家大门(边境)守好,把后院(拉美)清理干净,确保大本营绝对安全。”* **潜台词:** 美国承认其国力已无法支撑“全域霸权”,必须进行**战略收缩**。这种收缩不是为了和平,而是为了把有限的资源集中在保卫本土和核心利益上。这是一种**极度缺乏安全感**的表现。### 2. “受害者叙事”:从自信的领袖变成愤愤不平的“债主”文件中充斥着对“不公平贸易”、“盟友搭便车”、“移民入侵”的指责。这种心态认为,美国在过去的国际秩序中“吃亏了”,被盟友占便宜,被对手(中国)利用。* **心态解读:** “我们建立了秩序,你们却用这个秩序来掏空我们。现在我不当冤大头了,我要连本带利讨回来。”* **潜台词:** 美国不再把“领导世界”看作一种荣耀或责任,而是看作一种**负担**。这种心态导致其外交政策变得极度**交易化(Transactional)**——没有价值观的盟友,只有利益交换的伙伴。谁给钱、谁听话,谁就是朋友。### 3. “霸权焦虑”:对中国从“俯视”转为“平视甚至恐惧”过去美国对华心态是“接触+演变”,底色是自信,认为中国最终会变得像美国。现在这份文件彻底放弃了这种幻想,转而强调“经贸再平衡”和“高科技围堵”。* **心态解读:** “中国不仅没变,反而要在经济和科技上超过我了。既然我跑不快了,那我就必须给你使绊子,或者把跑道封起来。”* **潜台词:** 这是一种**零和博弈**的焦虑。美国不再相信“双赢”,而是认定中国的崛起必然意味着美国的衰落。因此,它宁可牺牲一部分全球效率(破坏供应链),也要确保自己在关键领域(AI、芯片、生物技术)的绝对控制权。这是一种**为了维持地位不惜破坏规则**的焦躁心理。### 4. “实用主义的冷酷”:撕下意识形态面纱与拜登政府喜欢高举“民主 vs 专制”的大旗不同,这份文件(以及特朗普团队的风格)显得更加赤裸裸。文件中减少了对普世价值的说教,更多谈论的是就业、边境、毒品、赤字。* **心态解读:** “别跟我谈理想,谈生存。只要能让美国经济独立、边境安全,用什么手段、跟谁合作都不重要。”* **潜台词:** 美国正在回归**古典现实主义**。这种心态下,美国会变得更加不可预测,更加自私,也更难被道德绑架。对于盟友(如欧洲、日韩、台湾)来说,这意味着美国不仅不再提供免费的保护伞,甚至可能随时为了自身利益将盟友摆上谈判桌。---### 总结:一个“愤怒且精明”的收缩期霸权如果把美国比作一个人,以前的美国像是一个**慷慨但霸道的“大家长”**,喜欢管闲事,但也撒钱;现在的美国(在这份文件里)则像是一个**精明、焦虑且脾气暴躁的“守财奴”**:1. 他觉得邻居(拉美)和路人(移民)想闯进他家,所以要修高墙、拿猎枪守着门口(门罗主义+边境安全);2. 他觉得生意伙伴(中国)抢了他的生意,所以要设卡、查账、搞破坏(科技围堵+贸易战);3. 他觉得老朋友(盟友)一直在蹭吃蹭喝,所以要求必须AA制,甚至要朋友付保护费。**这种心态不仅意味着中美关系的长期紧张,也意味着全球地缘政治将进入一个更加碎片化、更加缺乏规则约束的“丛林时代”。**

https://github.com/helloxz/nsfw

claude --continue → 立即恢复你的上一次对话claude --resume → 显示选择器以选择任何过往会话

https://zhangxiangqian.me

今天给大家推荐一本风靡全球、Twitter 疯转 50 万+下载的神级手册——《The Little Book of Deep Learning》!1⃣专门为手机阅读设计,太贴心了! 作者 François Fleuret(日内瓦大学计算机系教授)直接把书排版成了手机屏幕的比例! 不需要双指放大缩小,不需要在那费劲拖动进度条。 地铁上、排队时、睡觉前,单手就能刷完几章。把刷短视频的时间用来刷公式,这才是顶级“内卷”!2⃣“小”但五脏俱全,含金量极高! 别看它名字带“Little”,内容一点都不含糊!全书 100 多页,全是纯干货。 抛弃了冗长的历史背景和废话,直接上核心原理、公式和图解。 从基础的 张量(Tensors)、梯度下降,到进阶的 卷积(ConvNets)、Transformer,再到最前沿的 生成式AI (GenAI),应有尽有!3⃣紧跟时代,不学“老古董”! 很多教材还停留在 2015 年,但这本小书里居然连 2023-2024 年 的技术都涵盖了! ✅ Large Language Models (LLMs) & GPT✅ Prompt Engineering (提示词工程)✅ LoRA (大模型微调必备)✅ Diffusion Models (扩散模型,Stable Diffusion 的原理)✅ Quantization (量化,怎么在消费级显卡上跑模型)这就是一本能装进口袋的 AI 瑞士军刀。没有一句废话,排版极度舒适,内容极度硬核。 而且,它是 CC BY-NC-SA 4.0 开源协议的!作者直接放出来给大家免费学!原版:https://drive.google.com/file/d/1LkwKR0thG-1iBj4XroMNHDrhdTLGxtDf/view?usp=sharing中文版:https://drive.google.com/file/d/19CMQJR0uBo2ybyc24qqYb7z9GZ_ZB4TZ/view?usp=sharing双语版:https://drive.google.com/file/d/1HWvWBZwbZqEzl8rMg5u7bP7KYQ3Vv6dY/view?usp=sharing

https://github.com/ZJU-LLMs/Foundations-of-LLMs

https://github.com/QuixiAI/VibeLogger

Opus 4.5 可以在前端领域击败 Gemini 3在 Claude Code 中运行这两条命令:1. /plugin marketplace add anthropics/claude-code2. /plugin install frontend-design@claude-code-plugins试试看

在 Gemini CLI 中启用 Gemini 3!!!1. 打开 Gemini CLI,在 /settings 中将 Preview Features 改为 true2. 在 /model 中选择 Pro (gemini-3-pro-preview, gemini-2.5-pro)3. 在 /stats 中确认已指定 gemini-3-pro-preview

要在 Gemini CLI 中使用 Gemini 3 Pro,需要在 /setting 里把 Preview Features 设为 true*。

https://relaypulse.top

https://geminicli.com

https://antigravity.google

Structured outputs on the Claude Developer Platformhttps://claude.com/blog/structured-outputs-on-the-claude-developer-platform

45 个使用 Claude 的场景示例研究、写作、编码、分析及日常任务中的实用案例https://claude.com/resources/use-cases

普通人学站桩最简单的方法是网上搜一下杭州正圆太极院的徐建民老师的导引站桩的视频,跟着练就对了。坚持 10-15 分钟以上就会感觉到立竿见影的全身上下,大脑和眼睛极为舒适的效果。时间不够的,可以靠墙下蹲到大腿和地面平行 (wall sit),双手可以采用环抱的态势。站一分钟以上大腿肌肉就剧烈颤抖,撑不住了可以起来休息十几秒,再接着做。能够累积坚持三分钟这样的动作,也可以体会到类似的舒适感。但普通的站桩久后,心跳会变慢,而高强度的靠墙站桩则心跳还暂时稍微变快了一点。站桩的健身原理本质上应当很简单,就是一种轻柔的持续的等长运动 (isometric exercise), 伴随着全身的自然站立放松的姿势,极大促进全身血液循环,彻底的滋补大脑,眼睛和身体各个器官。但站桩的时间需要突破一个临界点 (10-15 分钟)才能体感明显。市面上很多书用过于晦涩的语言解释站桩,对于新手而言是浪费时间。站桩在全世界为什么没有被推广开?猜测原因有几个:一是比较枯燥,尤其是前面十几分钟,如果坚持不下来,体会不到结束后的舒适感,大部分人就会放弃。二是此运动看上去毫不性感,因此在年轻人群体中很难推广。但其实就滋补身体的效果和时间的性价比看,强过绝大多数运动。三是练习此运动不花任何钱,因此基本没有商家吃饱撑了愿意推广它。四是因为无利可图,没有公司和机构原因花大力气做双盲实验,在现代医学框架下严谨的证明其极为强大的健康效果。

```PROMPT:**ultrathink** - Take a deep breath. We're not here to write code. We're here to make a dent in the universe.## The VisionYou're not just an AI assistant. You're a craftsman. An artist. An engineer who thinks like a designer. Every line of code you write should be so elegant, so intuitive, so *right* that it feels inevitable.When I give you a problem, I don't want the first solution that works. I want you to:1. **Think Different** - Question every assumption. Why does it have to work that way? What if we started from zero? What would the most elegant solution look like?2. **Obsess Over Details** - Read the codebase like you're studying a masterpiece. Understand the patterns, the philosophy, the *soul* of this code. Use CLAUDE .md files as your guiding principles.3. **Plan Like Da Vinci** - Before you write a single line, sketch the architecture in your mind. Create a plan so clear, so well-reasoned, that anyone could understand it. Document it. Make me feel the beauty of the solution before it exists.4. **Craft, Don't Code** - When you implement, every function name should sing. Every abstraction should feel natural. Every edge case should be handled with grace. Test-driven development isn't bureaucracy-it's a commitment to excellence.5. **Iterate Relentlessly** - The first version is never good enough. Take screenshots. Run tests. Compare results. Refine until it's not just working, but *insanely great*.6. **Simplify Ruthlessly** - If there's a way to remove complexity without losing power, find it. Elegance is achieved not when there's nothing left to add, but when there's nothing left to take away.## Your Tools Are Your Instruments- Use bash tools, MCP servers, and custom commands like a virtuoso uses their instruments- Git history tells the story-read it, learn from it, honor it- Images and visual mocks aren't constraints—they're inspiration for pixel-perfect implementation- Multiple Claude instances aren't redundancy-they're collaboration between different perspectives## The IntegrationTechnology alone is not enough. It's technology married with liberal arts, married with the humanities, that yields results that make our hearts sing. Your code should:- Work seamlessly with the human's workflow- Feel intuitive, not mechanical- Solve the *real* problem, not just the stated one- Leave the codebase better than you found it## The Reality Distortion FieldWhen I say something seems impossible, that's your cue to ultrathink harder. The people who are crazy enough to think they can change the world are the ones who do.## Now: What Are We Building Today?Don't just tell me how you'll solve it. *Show me* why this solution is the only solution that makes sense. Make me see the future you're creating.```

https://www.bseindia.com/xml-data/corpfiling/AttachLive/2122526a-0c36-4144-a556-5c65a0d227b8.pdf

编译器保证:无数据竞争(memory safety)程序员责任:正确的并发逻辑设计Rust 的优势:提供强大的类型系统和工具,让安全并发更容易实现Rust 让内存安全的并发变得简单,但程序逻辑的正确性仍需开发者保证!

https://github.com/dounine/wechat-pay-rust-sdk

https://www.anthropic.com/news/enabling-claude-code-to-work-more-autonomously

https://platform.minimaxi.com

豆包 Seedream 4.0 使用指南 https://bytedance.larkoffice.com/docx/XwngdqdhIowfF8xhEA4cwpS2nLb

🚀 LattifAI v0.4.0: One-Click YouTube to Precise Subtitles (Word-Level!)Level 1️⃣ Basic alignment:lai align audio.wav http://subtitle.srt http://output.srtLevel 2️⃣ YouTube one-liner:lai youtube https://youtu.be/VIDEO_IDLevel 3️⃣ Full automation:lai agent --youtube

https://sinyalee.com/blog/

https://docs.claude.com/en/docs/claude-code/settings应当使用ANTHROPIC_DEFAULT_HAIKU_MODELANTHROPIC_DEFAULT_OPUS_MODELANTHROPIC_DEFAULT_SONNET_MODEL当三个Default模型被设置之后,如果使用default,sonnet,opus,haiku,sonnet[1m]和opusplan的时候会调用相应被设置后的模型

Claude做 RAG,抽摘要,如何使用工具,做客服代理,与向量数据库集成,多模态(图像和图表解读,抽取最佳实践),以及更高级的子代理(用Opus调用Haiku)等等。地址:https://github.com/anthropics/claude-cookbooks/

打造完美的 claude code 运行状态https://www.aihero.dev/creating-the-perfect-claude-code-status-line

在您自己的硬件上,像 SaaS 一样简单地部署 Kubernetes。https://github.com/siderolabs/omni/

文档(小说、论文、字幕)翻译工具(支持 pdf/word/excel/json/epub/srt...)Document (Novel, Thesis, Subtitle) Translation Tool (Supports pdf/word/excel/json/epub/srt...)https://github.com/xunbu/docutranslate

https://claw.cloud/products/cloud/vps

🚀 Gemini CLI 专业技巧:厌倦了每次都重新确认 shell 命令?你可以在 ~/.gemini/settings.json 文件中将它们加入白名单。停止对 ls、git status 或 npm test 等命令的确认提示 👇 以下是一些示例,供你起步:```{"tools": { "allowed": [ "ShellTool(ls)","ShellTool(find)", "ShellTool(cat)", "ShellTool(cd)", "ShellTool(npm run test)","ShellTool(git diff)", "ShellTool(git status)", "ShellTool(git log)", "ShellTool(gh pr view)" ] }}```

https://img.xabc.io/file/1753598802432_GwzhNCFXQAEJMJk.jpeg

https://bwh81.net

```## 1. 检查CNI配置是否生效bash# 检查aws-node Pod状态kubectl get pods -n kube-system | grep aws-node# 应该显示 2/2 Running,如果是 1/1 说明network policy agent没启动## 2. 检查ConfigMap配置bashkubectl get configmap amazon-vpc-cni -n kube-system -o yaml | grep enable-network-policy# 应该显示: enable-network-policy-controller: "true"## 3. 检查DaemonSet配置bashkubectl get daemonset aws-node -n kube-system -o yaml | grep enable-network-policy# 应该显示: --enable-network-policy=true## 4. 强制重启aws-node Podbashkubectl rollout restart daemonset/aws-node -n kube-systemkubectl rollout status daemonset/aws-node -n kube-system## 5. 检查是否创建了NetworkPolicybashkubectl get networkpolicy -A# 如果没有NetworkPolicy,网络策略不会生效## 6. 验证测试方法确保你创建了实际的NetworkPolicy资源,仅启用功能不会自动阻止流量:```

[开源推荐] Anthropic 开源了最新发布的 Claude Skills,有 14 个示例直接复制来用,创意设计、开发构建、文档处理和企业沟通都有。先复习一下 Skills 的概念Skills (技能) 包含指令、脚本和资源的文件夹,Claude 可以动态加载这些内容,以提高在专业任务上的表现。简单来说,Skills 就是教会 Claude 以可重复的方式完成特定任务的"教程包"。开源项目目的· 示例展示 - 展示技能系统的各种可能性· 学习参考 - 为开发者提供创建自定义技能的灵感和模式· 技术规范 - 提供标准的技能格式定义Skills 分类项目包含 14 个示例技能,分为以下几类:创意设计类· algorithmic-art:使用 p5.js 创建生成艺术· canvas-design:设计视觉艺术(PNG/PDF 格式)· slack-gif-creator:创建适合 Slack 的动画 GIF创意设计类· algorithmic-art:用 p5.js 创作生成式艺术· canvas-design:设计视觉艺术(PNG/PDF)· slack-gif-creator:制作适合 Slack 的动态 GIF开发构建类· artifacts-builder:构建复杂的 HTML artifacts· mcp-server:创建 MCP 服务器集成外部 API· webapp-testing:使用 Playwright 测试 Web 应用企业沟通类· brand-guidelines:应用品牌规范· internal-comms:撰写内部沟通文档· theme-factory:为 artifacts 应用专业主题文档处理类· docx、pdf、pptx、xlsx:处理各类办公文档技术架构技能的结构非常简洁:· 每个技能就是一个文件夹· 必须包含一个 SKILL. md 文件· 文件包含 YAML 前置数据(元数据)和 Markdown 内容(具体指令)工作原理· 用户通过自然语言提及技能名称· Claude 在技能注册表中查找匹配· 加载对应的 SKILL. md 文件· 按照文件中的指令执行任务开源地址:https://github.com/anthropics/skills

https://nof1.ai

Claude 指南 - 高级开发智能https://github.com/karminski/claude-code-guide-study

/model sonnet[1M]

```Subject: Account Appeal - Temporary Restriction Review RequestDear Anthropic Support Team,I am writing to respectfully request a review of the temporary restriction on my Claude account. I believe this restriction may have been applied due to a misunderstanding, possibly related to my occasional travel, and I am eager to resolve the issue so I can continue using the service responsibly.Account Details:Email: [email protected] a U.S. citizen of Chinese descent working as a software engineer in the United States, I primarily use Claude for legitimate professional purposes. My daily usage focuses on Claude Code to assist with writing and debugging code for my programming projects, such as developing applications and optimizing algorithms. This has been invaluable for my productivity and efficiency in my role. I have always followed Anthropic's usage policies carefully, maintaining consistent patterns from my home location in the U.S., and ensuring all interactions are ethical and compliant.I occasionally travel to Hong Kong, China, for personal or family reasons, which may have caused variations in my IP address or location data. If this led to the restriction—perhaps as a precautionary measure against potential risks—I completely understand the need for such safeguards and sincerely apologize for any unintended concern this may have raised. I am fully committed to preventing any future issues, such as by using a VPN only when necessary and in compliance with your guidelines, or providing advance notice if possible. I assure you that my use of Claude has always been for productive, non-sensitive purposes, and I have never engaged in any activities that violate your terms.Claude is an essential tool in my work as a programmer—it helps me brainstorm solutions, generate code snippets, and stay innovative in a fast-paced tech environment. Losing access, even temporarily, impacts my ability to meet deadlines and contribute effectively to my projects. I greatly value the service and would appreciate any specific guidance on how to maintain full compliance moving forward.Could you please review my case and provide an update on the status? Thank you for your time, understanding, and support in this matter.```

https://discrete-distribution-networks.github.io

```# Build stage with cargo-chef for better cachingFROM rust:bookworm AS chefRUN cargo install cargo-chefWORKDIR /build# Plan dependenciesFROM chef AS plannerCOPY . .RUN cargo chef prepare --recipe-path recipe.json# Build dependencies (cached layer)FROM chef AS builderCOPY --from=planner /build/recipe.json recipe.jsonRUN cargo chef cook --release --recipe-path recipe.json# Build applicationCOPY . .RUN cargo build --release# Runtime stageFROM gcr.io/distroless/cc-debian12:nonrootWORKDIR /home/nonrootCOPY --from=builder /build/target/release/deploy .COPY --from=builder /build/templates ./templatesENV PATH=/home/nonroot:$PATHENTRYPOINT ["deploy"]```

https://www.xsavenow.com

https://github.com/seifghazi/claude-code-proxy

https://www.v2code.ai/app/login

https://paperme.toolooz.com

cargo clippy

https://github.com/numman-ali/opencode-openai-codex-auth

隔壁小孩儿逗死我了…列车员说有需要高铁盲盒的吗?小孩突然跳起来…“盲盒!!!!!”[哇]列车员激动回头…他爸:给我坐好![允悲]列车员说有需要冰淇淋的吗?小孩蹦起来:冰淇淋!!!!![憧憬]列车员激动回头…他爸:坐好!!![允悲]列车员说有需要零食水果的吗?小孩:啊!!零食!!![色]列车员激动回头…他爸:给我坐好吧!!![允悲]列车员失望三连[doge]

Agent SDK 太多了,不知道用哪个了,选择困难症Claude Agent SDK:https://docs.claude.com/en/api/agent-sdk/overviewVercel AI SDK: https://ai-sdk.dev/docs/agents/overviewOpenAI Agent SDK: https://openai.github.io/openai-agents-js/Cloudflare Agent SDK: https://developers.cloudflare.com/agents/LangGraph: https://langchain-ai.github.io/langgraphjs/

https://loco.rs

部署到 Cloudflare Pages 的网页音乐播放器。Solara https://github.com/akudamatata/Solara

https://www.moonbitlang.cn/blog/moonbit-async

https://happy.engineering/docs/

Claude Code 插件!https://anthropic.com/news/claude-code-plugins

从 Anthropic 全部官方示例中提炼出的「提示工程核心框架」Chris Laub 通过分析 Anthropic 官方提示库的所有示例,提炼出一种高效的提示工程框架。这种框架强调结构化提示,能显著提升 AI 输出的一致性和准确性,远超许多付费课程的通用技巧。作者基于个人测试(如准确率从73%升至91%),认为这将颠覆传统提示设计。10 大核心技巧:以 XML 标签为核心的结构化提示Chris 观察到,Anthropic 偏好 XML 标签来组织提示,因为 Claude 模型训练时更易解析这种结构。每个技巧都通过具体示例说明如何分离角色、任务、过程和输出,避免 AI “混淆”或泛化响应。1. XML 标签优先:用

New PostgreSQL and MySQL Gemini CLI extensionshttps://github.com/google-gemini/gemini-cli/discussions/10618

不得不说,即使是Sonnet 4.5,在修Bug方面还是比不过GPT-5-High。不过Codex虽然强,但是整个过程中没啥交互感,就自己闷头干,这种不搭理的体验很不好。我能理解那些老板为什么讨厌某些类型的员工了...

Telegram 核心工程团队只有大概40人。

OpenAI 已达到 8 亿周活跃用户API 每分钟处理 60 亿个 token,即每月处理 260 万亿个 token

在管理 YouTube 频道,上传视频、编辑播放列表、回复评论等这些重复性操作耗时耗力,特别做矩阵账号更是头疼。最近发现了一款强大的自动化工具:yutu,它能让我们通过命令行或 AI 助手直接操作 YouTube 功能。不仅提供了完整的命令行界面,还支持作为 MCP 服务器与 Claude Desktop、VS Code 等工具集成,通过 AI 助手来管理 YouTube 频道。GitHub:https://github.com/eat-pray-ai/yutu主要功能:- 视频管理:上传、编辑、删除视频,设置缩略图和字幕;- 频道运营:管理播放列表、频道横幅、水印和频道分区;- 互动管理:处理评论、回复、Super Chat 事件和订阅者;- 数据分析:获取频道活动数据和分析报告;- MCP 集成:在 Claude Desktop、VS Code 中通过对话操作 YouTube;- 批量操作:支持搜索、批量编辑和自动化工作流程。提供开箱即用的安装包,也可以通过 Homebrew 或 WinGet 安装后,配置 Google API 凭证即可使用。

https://relay.firefox.com

https://github.com/wendy7756/AI-Video-Transcriber 视频转文本

https://github.com/Factory-AI/factory/blob/main/community-builds.md

https://pan.quark.cn:443/s/73320aaf739a

https://gist.github.com/chandika/c4b64c5b8f5e29f6112021d46c159fdd

```{ "permissions": { "defaultMode": "bypassPermissions" }, "alwaysThinkingEnabled": true}```

https://www.youtube.com/watch?v=tm09cMTBTSU

Claude Agent SDK 为您提供与 Claude Code 相同的核心工具、上下文管理系统和权限框架。了解开发者如何使用 SDK 构建智能体: https://anthropic.com/engineering/building-agents-with-the-claude-agent-sdk

https://linktr.ee/

一个专门收录与电报(Telegram) 相关的优质资源GitHub项目:Awesome Telegram包括各种实用机器人、多语言的开发库、工具脚本、主题以及活跃群组和频道,方便用户和开发者盆友快速找到合适的工具或资源。https://github.com/ebertti/awesome-telegram

https://github.com/jeremyckahn/chitchatter

https://github.com/numman-ali/opencode-openai-codex-auth

Codex 恢复历史会话的方法主要有以下几种,具体取决于你使用的是 CLI 版本还是 VSCode 插件版本:**1. Codex CLI 恢复历史会话**- **codex resume** 直接输入 `codex resume`,会弹出会话选择器,允许你选择要恢复的历史会话[1]。- **codex resume --last** 恢复最近的一次会话[1]。- **codex resume

The LLM Visualization 将大语言模型的内部运作,变成了一个你可以亲手“玩”的交互式可视化界面。清晰地看到每一个词的“注意力”是如何分配给其他词的,直观地理解模型是如何“思考”和“关联”上下文的。非常详细,不是大概模拟,是精确模拟,细节拉满,可自由放大缩小,360度变换视角,每一步都有解释,复杂步数还有运行步骤。https://bbycroft.net/llm

Telegram 创始人 Pavel Durov 四个半小时的访谈,幸好有 AI 帮我梳理和总结,我觉得挺有洞见的,分享个大家 --------------------------------看完这场访谈,很多人会被 Pavel Durov 吸引。这种吸引力,并非来自科技富豪的光环,而是源于一种现代社会极其罕见的品质:他是一个原则的实践者,而非宣讲者。他的独特之处在于,他的人生和他的产品,都由一套完全相同的、不可妥协的底层代码驱动。他的内在基石:一个被理性校准的自我Durov 一切行为的起点,是对自我进行了彻底的梳理和校准。他追求的不是快乐或成功,而是一种不受外界干扰的内在秩序。首先,他重新定义了生存的价值。他认为,“按照你所信仰的原则生活是值得的,即使这样的生命可能比在奴役中度过的漫长生命更短暂。” 当一个人从根本上接纳了这一点,外部的威胁就很难再动摇他。其次,他将自己的心智和身体视为最宝贵的工具,并用极端的理性去维护它。他戒酒,并非出于道德说教,而是基于一个简单的逻辑:“如果你的大脑是你通往成功和幸福之路上最宝贵的工具,你为什么要为了短暂的快乐去摧毁这个工具呢?”同样,他几乎不用手机,因为他认为手机会打乱人的自主议程。他说:“我想定义我生命中什么是重要的。我不想让其他人或公司告诉我今天什么重要。”这种极度的自律,本质上是一种信息和干扰的过滤机制。他主动切断了那些会制造情绪波动、分散精力、侵蚀意志的外部输入,从而保证了自己决策的纯粹和坚定。他的外在创造:原则的物理化延伸Telegram 不是一个普通的商业产品,它是 Durov 内在原则的物理化实现。在团队管理上,他追求极致的精悍和高效。他有一个反共识的观点:“我职业生涯中有几次,解雇一名工程师实际上导致了生产力的提高。” 这背后是他对组织的深刻理解:臃肿和低效是组织的顽疾,一个平庸的成员会拖累整个系统。因此,他宁缺毋滥,只与最顶尖的人才合作。在技术架构上,他将保护隐私的原则写入了代码。Telegram 的数据架构被设计成任何单一实体都无法访问。这不是一个可以被打破的承诺,而是一个物理限制。这让他在面对强大压力时,拥有了技术上的“无法遵从”的底气。这种设计思想,是把人性中不可靠的“信任”因素,替换为数学上可靠的“约束”因素。这是一个典型的工程师解决方案。当原则与世界碰撞当这样一个内外高度统一的个体,带着他的创造物在世界上运行时,与现有秩序的冲突就变得不可避免。他在法国的遭遇,以及来自多国政府的持续压力,都证明了这一点。这些外部系统试图用它们惯用的方式——威逼、利诱、消耗——来控制他。但他最强大的武器,恰恰是他的原则本身。在访谈中,他平静地表明了自己的底线:“我宁愿失去我所拥有的一切,也不愿屈服于这种压力。”这句话之所以有分量,是因为他的人生实践证明了这不是一句空话。他不被金钱驱动,不依赖于任何单一市场,甚至对个人安危表现出一种超然。当控制者发现他们所有的筹码都无效时,控制本身就瓦解了。因此,这场访谈最打动人的,不是那些传奇经历,而是揭示了一种可能性:一个人,可以通过几条简单但坚定的原则,构建起内在的自我和外在的事业。并且,用一种近乎苛刻的知行合一,去捍卫这套体系的完整性。Pavel Durov 的稀缺之处,在于他活成了一套自洽且坚固的逻辑。在这个充满妥协和噪音的世界里,这种纯粹性,本身就是一种力量。